Datenbasierte Verbesserung von Simulationsmodellen zur Identifikation von stochastischen digitalen Zwillingen von Brücken

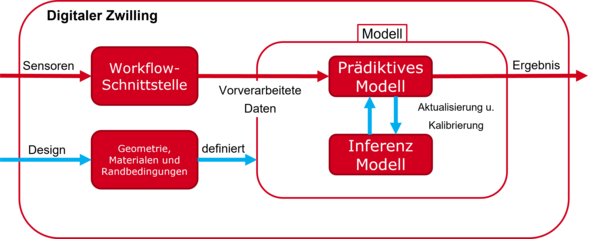

Simulationsbasierte Methoden sind der Standard für die Bemessung von Brücken, vor allem in Bezug auf das mechanische Verhalten unter verschiedenen Belastungsbedingungen. Auf der Grundlage dieser Simulationsmodelle kann ein digitaler Zwilling der Brücke erstellt werden, der die Möglichkeit bietet, den Informationsgehalt der regelmäßigen Inspektionen und/oder Überwachungsdaten durch weitere Informationen zu erhöhen. Mögliche Anwendungen sind vielfältig und umfassen virtuelle Sensormessungen an Stellen, die sonst unzugänglich sind bzw. zu teuer sind, um sie mit einem Sensorsystem auszustatten, Untersuchungen der aktuellen Leistungsfähigkeit des Bauwerks, z.B. unter Verwendung der tatsächlichen Belastungshistorie in einer Ermüdungsanalyse anstelle der Entwurfslasten, oder die Planung und Priorisierung von Instandhaltungsmaßnahmen sowohl für eine einzelne Brücke als auch für eine Reihe ähnlicher Brücken. Sobald das Bauwerk gebaut ist, weicht der tatsächliche Zustand bzw. die Eigenschaften des Bauwerks aus verschiedenen Gründen in der Regel stark vom Entwurf ab. Folglich liefert ein digitaler Zwilling, der auf dem ursprünglichen Simulationsmodell aus dem Entwurf basiert, in der Regel nur eine begrenzte Vorhersagequalität. Es ist von großer Bedeutung, das Entwurfsmodell schrittweise zu verbessern, bis die Prognose des Simulationsmodells mit den Sensormesswerten innerhalb bestimmter vordefinierter Grenzen übereinstimmt. Dabei ergeben sich eine Reihe von Herausforderungen, die in diesem Projekt untersucht werden sollen.

Die erste Herausforderung ist die inhärente Unsicherheit, die sowohl mit den Modellierungsannahmen (z.B. ein linear-elastisches Modell) innerhalb des digitalen Zwillings als auch mit den Parametern, die in diesen Modellen verwendet werden (z.B. Elastizitätsmodul), verbunden ist. Es wird ein automatisiertes Verfahren auf der Grundlage der Bayes'schen Inferenz entwickelt, das es ermöglicht, unsichere Sensordaten (sowohl von visuellen Inspektionen als auch von Überwachungssystemen) in eine stochastische Aktualisierung der Modellparameter einzubeziehen. Diese ermöglicht die Berechnung von Wahrscheinlichkeitsverteilungen anstelle von deterministischen Simulationsergebnissen. Besondere wichtig ist es dabei, eine Methodik zu entwickeln, die mit einem konstanten Fluss von Überwachungsdaten umgehen kann, d.h. ein kontinuierliches Aktualisierungsverfahren. Dies hat zur Folge, dass die aus dem digitalen Zwilling abgeleiteten Leistungsindikatoren, die als Grundlage für die Entscheidungsfindung dienen, mit einer Unsicherheit behaftet sind. Auf der Grundlage genauer und optimal platzierter Sensoren sowie realistischer Modellierungsannahmen lässt sich diese Unsicherheit oft verringern.

Da es kein ''richtiges'' Modell gibt, ist die Suche nach einem guten Modell ein komplexer Prozess, der mehrere Iterationen zwischen Modellverbesserung und -prüfung umfasst. Der visuelle Vergleich von Simulationsergebnissen aus kalibrierten Modellen mit experimentellen Daten ist eine Herausforderung. Insbesondere die manuelle visuelle Identifizierung von Modellfehlern ist auf eine geringe Anzahl von Daten beschränkt. Für eine automatisierte Analyse ist es wichtig a) zu ermitteln, wo das Simulationsmodell ungenau ist und b) welche Verbesserungen am Modell möglich sind. Die Identifizierung der Ursachen einer Modellungenauigkeit wird einerseits durch eine große Menge an Daten erschwert, die in der Regel in Überwachungssystemen verfügbar sind, und andererseits durch die Tatsache, dass Modellierungsannahmen (z.B. in Bezug auf die Randbedingungen wie feste vs. flexible Stütze) oft Sensorabweichungen an Stellen auslösen, die nicht mit dem Ort des Modellfehlers übereinstimmen. Die Identifizierung potenzieller Verbesserungen in b) basiert auf Techniken des maschinellen Lernens. Die Idee ist, den Ingenieur, der physikalisch basierte Modelle entwickelt, dabei zu unterstützen, relevante physikalische Phänomene zu verstehen, die im Modell nicht korrekt dargestellt sind. Dazu gehören räumlich variable Modellparameter über Zufallsfelder oder Wörterbuchansätze für konstitutive Gesetze, bei denen die wahrscheinlichste Modellverbesserung aus einem Wörterbuch von parametrisierten Funktionen ausgewählt wird.

Um die stochastische Analyse für komplexe Strukturen und insbesondere für Quasi-Echtzeitanwendungen durchführen zu können, ist die Simulationszeit von größter Bedeutung, d.h. die Rechenzeit für eine einzelne Auswertung des digitalen Zwillings sollte so kurz wie möglich sein. Daher werden Antwortflächenverfahren entwickelt, die auf dem rechenaufwändigen Vorwärtsmodell trainiert werden und dann in einer nachfolgenden Auswertung das Vorwärtsmodell ersetzen können. Dies erfordert zielgerichtete Fehlerschätzungen zur Begrenzung des Approximationsfehlers der Response Surface. Dabei sollen Metamodelle auf Basis von Gaußschen Prozessen oder Physics Informed Neural Networks eingesetzt werden.

Für dieses Projekt sind vier Arbeitspakete geplant, (siehe Abbildung 2).

Projektmeilensteine im Rahmen des SPP-Programms

Die Zuverlässigkeit simulationsbasierter Digitaler Zwillinge für Brücken wurde verbessert und die Modellgüte quantifiziert, indem Modellstrukturunsicherheiten in den Prozess der Parameteridentifikation aus Monitoring-Daten integriert wurden. Dadurch können die Modelle die tatsächliche Variabilität der Felddaten widerspiegeln und ermöglichen eine Vorhersage von KPIs mit realistischen Fehlerschranken als Grundlage für fundierte Entscheidungen.

Ein adaptiver Ansatz basierend auf Gaußschen Prozessen wurde entwickelt, um schnelle und verlässliche Näherungen komplexer Brückenmodelle für Monitoring und Bewertung bereitzustellen. Diese Ersatzmodelle sind eine Voraussetzung für simulationsbasierte Digitale Zwillinge, die quasi-echtzeitfähige Berechnungen mit engen Genauigkeitsanforderungen erfordern.

Gaußsche Mischmodelle sowie die quantifizierten Modellstrukturunsicherheiten wurden genutzt, um gezielte Modellverbesserungen für den Digitalen Zwilling zu steuern. Mit diesem Ansatz konnten Bereiche identifiziert werden, in denen die Simulation am stärksten vom realen Brückenverhalten abwich – was eine gezielte Verfeinerung des Digitalen Zwillings zur besseren Zustandsbewertung ermöglichte.

Der vollständige Kalibrierungsprozess – einschließlich der Modellstrukturunsicherheit – wurde an einem vereinfachten thermischen Modell der Nibelungenbrücke demonstriert, basierend auf realen Monitoring-Daten. Dies führte zu genauen, unsicherheitsbewussten Vorhersagen des thermischen Verhaltens und zeigte, wie kalibrierte Modelle die Interpretation von Sensordaten verbessern und die Beurteilung des aktuellen und zukünftigen Brückenzustands unterstützen können.

Anprechpartner

Publikationen

Peer-Reviewed Journal Paper

Andrés Arcones, D.; Weiser, M.; Koutsourelakis, P.-S.; Unger, J.F.: Model Bias Identification for Bayesian Calibration of Stochastic Digital Twins of Bridges. Applied Stochastic Models in Business and Industry (2024), pp 1-26, https://doi.org/10.1002/asmb.2897

Becks, H., Lippold, L., Winkler, P., Moeller, M., Rohrer, M., Leusmann, T., Anton, D., Sprenger, B., Kähler, P., Rudenko, I., Arcones, D. A., Koutsourelakis, P.-S., Unger, J. F., Weiser, M., Petryna, Y., Schnellenbach-Held, M., Lowke, D., Wessels, H., Lenzen, A.,…Hegger, J. (2024). Neuartige Konzepte für die Zustandsüberwachung und -analyse von Brückenbauwerken – Einblicke in das Forschungsvorhaben SPP100+/Novel Concepts for the Condition Monitoring and Analysis of Bridge Structures – Insights into the SPP100+ Research Project. Bauingenieur, 99(10), 327-338. https://doi.org/10.37544/0005-6650-2024-10-63

Andrés Arcones, D.; Weiser, M.; Koutsourelakis, P.-S.; Unger, J.F. (2024): Bias Identification Approaches for Model Updating of Simulation-Based Digital Twins of Bridges. Research and Review Journal of Non-Destructuve Testing, Vol. 2, Art. 2, https://doi.org/10.58286/30524

Andrés Arcones, D.; Weiser, M.; Koutsourelakis, P.-S.; Unger, J.F.: Embedded Model Bias Quantification with Measurement Noise for Bayesian Calibration. ArXiv preprint (2024). https://doi.org/10.48550/arXiv.2410.12037

Konferenz und andere VÖ

Andrés Arcones, D.; Weiser, M.; Koutsourelakis, P.-S.; Unger, J.F.: Evaluation of model bias identification approaches based on Bayesian inference and applications to Digital Twins. In: UNCECOMP 2023 – 5th International Confetence on Uncertainty Quantification in Computational Science and Engineering, 12-14 June 2023, Athens, Greece, pp. 67-81.

Andrés Arcones, D.; Weiser, M.; Koutsourelakis, P.-S.; Unger, J.F.: A Bayesian Framework for Simulation-based Digital Twins of Bridges. In: ce/papers (EuroStruct 2023), Vol. 6 (2023), Iss. 5, pp. 734-740.

Villani, P.; Unger, J.F.; Weiser, M.: Adaptive Gaussian Process Regression for Bayesian Inverse Problems. In: Proceedings of the Conference Algoritmy 2024, 15-20 March 2024, Vysoké Tatry, Slovakia, pp. 214-224.

Andrés Arcones, D.; Weiser, M.; Koutsourelakis, P.-S.; Unger, J.F.: Uncertainty Quantification and Model Extension for Digital Twins of Bridges through Model Bias Identification. In: ECCOMAS 2024 – 9th European Congress on Computational Methods in Applied Sciences and Engineering, 3-7 June 2024, Lisbon, Portugal.

Unger, J.F., Andrés Arcones, D.: Uncertainty Quantification and Model Extension for Digital Twins through Model Bias Identification. In; FrontUQ2024, 24-27 September 2024, Braunschweig.

Andrés Arcones, D.; Unger, J.F.: Modell- und Parameterusicherheiten am Beispiel eines digitalen Brückenzwillings. In: Tagusband 11. Jahrestagung des DAfStb mit 63.Forschungskolloquium der BAM. 16.10. – 17-10.2024, Berlin. S. 218-223.

Unger, J.F., Robens-Radermacher, A., Andrés Arcones, D., Saif-Ur-Rehman, S.-U.-R.: Bayesian model updating for predictive digital twins under model form uncertainty. In: DTE-AICOMAS 2025, 17-21 February 2025, Paris, France

Andrés Arcones, D., Weiser, M., Koutsourelakis, P.-S., Unger, J.F.: Incorporating model form uncertainty in digital twins for reliable parameter updating and quantities of interest analysis. In: 95th Annual GAMM Meeting, 7-11 April 2025, Poznan, Poland